Мир буквально утопает в данных, причем 90% из них было сгенерировано за последние два года[1]. Каждый день мир производит 2,5 квинтиллиона байт данных[2], и их объем увеличивается по экспоненте. Взрывной рост Интернета вещей (Internet of Things, IoT) сулит существенный прирост данных, при этом к 2020 г. 40 процентов всех данных будут поступать от всевозможных датчиков[3]. Сегодня один авиалайнер способен в течение рейса сгенерировать 1 терабайт данных[4], а крупное международное предприятие розничной торговли ежечасно получает 2,5 петабайта клиентских данных[5]. Вместе с тем 99,5% всех данных остаются без движения: они не используются и не анализируются[6].

Интернет вещей создает своего рода «аналитический императив», требующий нарастить долю данных, превращаемых в ценную оперативную информацию, которая способствует повышению операционной ценности и маневренности бизнеса.

На первом этапе развития Интернета данные загружались в аналитические системы. Это хорошо работало для больших объемов исторических данных, например, когда нефтяной компании для внедрения новых методов добычи требовался пакетный анализ сейсмических данных за несколько лет. С не меньшим успехом это работает и теперь для таких приложений, как, например, подключенные торговые автоматы, которые передают в облако всего несколько байт, когда необходимо пополнить запасы того или иного товара, и которым не требуются ни большая полоса пропускания, ни срочная обработка в реальном времени.

Появление Всеобъемлющего Интернета (Internet of Everything, IoE) вызвало к жизни массу высокоскоростных приложений реального времени, для работы с которыми необходим новый подход, получивший название «распыленных вычислений»[7]. Расширяя функционал облака вплоть до границы сети, распыленные вычисления приближают средства анализа к источникам данных, делая возможными как обработку в реальном времени, так и мгновенную ответную реакцию. Вместо того, чтобы перемещать массивы исходных данных, такие вычисления сортируют и индексируют данные локально, передавая в облако лишь аварийные уведомления и сообщения о нештатных ситуациях.

Благодаря перемещению средств анализа ближе к данным датчики транспортной инфраструктуры могут определить приближение специального транспорта и тут же скорректировать работу светофоров, чтобы обеспечить быстрый и безопасный проезд. А, скажем, нефтегазовая компания с помощью температурных и акустических датчиков сможет выявить аномальные условия и немедленно предпринять соответствующие меры для предотвращения выброса.

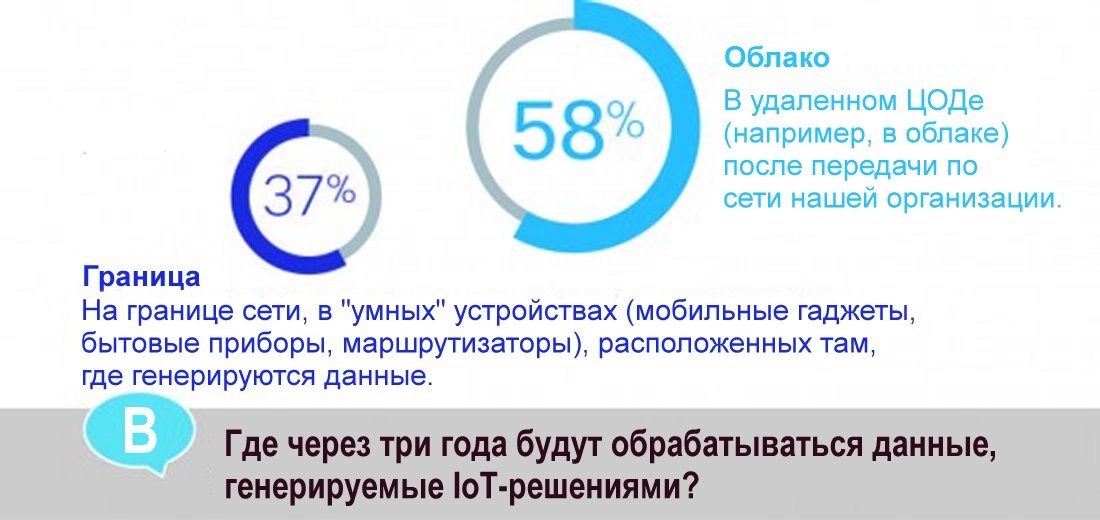

Переход к аналитике с помощью распыленных вычислений уже идет полным ходом. Во время недавнего опроса специалистов по информационным и операционным технологиям 37% респондентов заявили, что через три года «бОльшая» часть IoT-данных будет обрабатываться локально, на границе сети.

Аналитика с помощью распыленных вычислений потребует гибкой сетевой архитектуры, где такие элементы, как политики, будут располагаться в облаке, а функции обработки реального времени переместятся к границе. Менее срочные данные будут по-прежнему передаваться в облако для долговременного хранения и ретроспективного анализа. Потребуются также стандартизация интерфейсов устройств и данных, интеграция с облаком и масштабируемая инфраструктура политик.

В будущем возрастет значимость таких функций, как потоковая аналитика для обработки непрерывных потоков входящих данных, обучение машин для постепенного повышения производительности IoT-приложений, а также визуализация данных.

вице-президент и генеральный менеджер

отдела корпоративных технологий Cisco

[1] “Big Data and What it Means,” U.S. Chamber of Commerce Foundation.

[3] Trillions of Sensors Feed Big Data,” Signal Online, February 1, 2014.

[4] “If You Think Big Data’s Big Now, Just Wait,” TechCrunch, August 10, 2014.

[6] “Big Data, Bigger Digital Shadows, and Biggest Growth in the Far East,” IDC, February 2013.

[7] Или, в буквальном переводе, туманные вычисления (от fog computing).

Горячие темы